Wij mensen denken natuurlijk dat we met onze ogen heel veel kunnen zien. Dat klopt eigenlijk niet. Er is vooral heel veel dat we niet kunnen zien. Samen met Paul Voerman, Head of Innovations bij Tricas, leg ik in onderstaand artikel uit waar we staan en hoe robots ons met hun fantastische ogen kunnen helpen.

We behandelen eerst de technische kant en gaan dan een paar voorbeelden geven van het nut van robot ogen.

Resolutie

Robots kunnen met een veel hogere resolutie kijken dan wij. Uit je oog komen twee miljoen zenuwen die het beeld dat op je netvlies valt, doorgeven aan je hersenen. Als je zenuwen met pixels vergelijkt, heeft het oog dus twee miljoen pixels. Een goede camera op een telefoon heeft met 20 miljoen pixels dus al het tienvoudige. Maar dat is nog maar het begin, want als je een robot zou gebruiken dan kan dit nog veel verder omhoog. Exponentieel je weet wel.

Contrast

Ons computer kleurenspectrum is meestal opgedeeld in 16.5 miljoen kleuren. Met moeite kunnen we als mensen 5 punten verschil zien. Dat is al knap maar een robot kan veel kleinere verschillen onderscheiden. De kleurverschillen tussen de bolletjes hieronder zijn lastig te zien voor ons maar geen enkel probleem voor een robotoog.

Een robot oog laat zich niet verleiden door de eigen interpretatie van de hersenen, dat doen mensen continu en dat verkleint bij ons de objectieve werkelijkheid helaas.

Snelheid

De snelheid van het menselijk oog in beelden per seconde meten is technisch niet te doen. Het gaat namelijk om of je iets ziet (draaiend wiel) en hoe goed (elke spaak van het wiel). Dat een camera het in iedere geval veel beter kan behoeft geen betoog eigenlijk. Om mooie slow motion opnames te maken is een framerate van 960 al vrij gebruikelijk. Dit verbleekt bij de 100.000 frames per seconde van gespecialiseerde camera’s voor super slow motion.

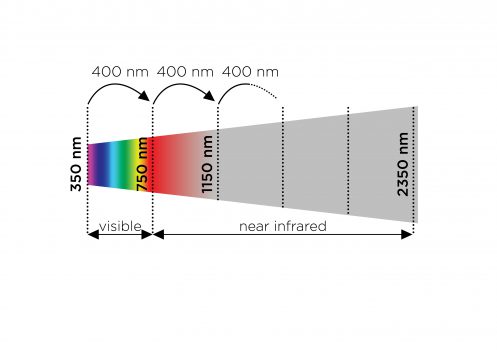

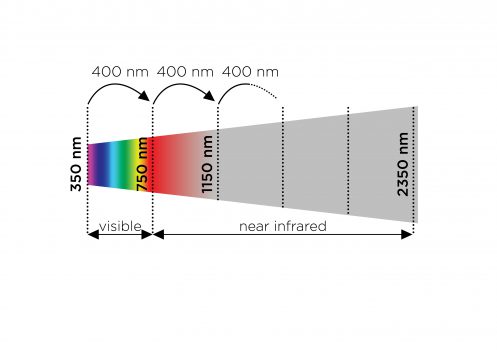

Een stukje in het elektromagnetisch spectrum

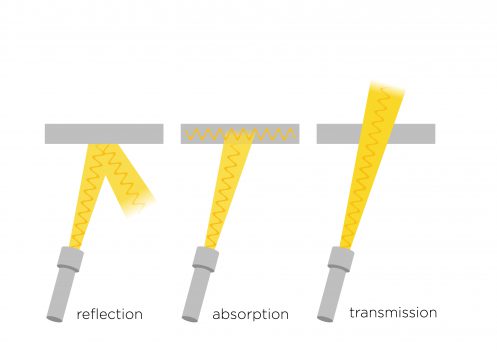

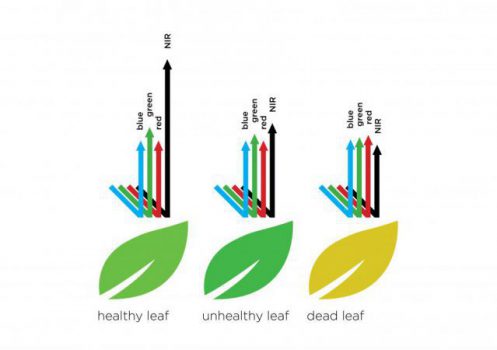

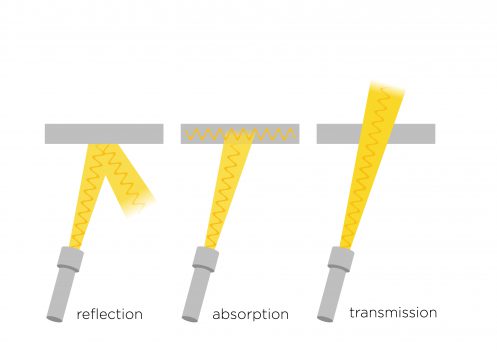

Op het spectrum van near-infrared staan onze ogen buitenspel. Kijk eens hierboven in het plaatje, dan zie je hoeveel we (onze ogen) eigenlijk missen! Het licht gedraagt zich in dit gedeelte van het spectrum namelijk niet anders dan in het voor ons zichtbare spectrum. Ook hier is het spel van reflectie, absorptie en doorlatend. Eigenschappen die voor ons niet zichtbaar zijn worden met near-infrared wel zichtbaar.

Toepassingen

We kunnen gelukkig robots en andere machines uitrusten met camera’s die erg goed, snel en scherp kunnen kunnen kijken. Wat zouden ze dan kunnen zien waar wij wat aan hebben? Hieronder een topje van de ijsberg. Er zijn namelijk duizenden toepassingen te verzinnen.

- Ongewenste vervuiling / schimmels op onze voeding. Dat lijkt me super! Je robot wijst in de winkel op het meest verse eten. Veel minder kans op voedselvergiftiging. Dat kleine puntje dat jij niet ziet is helder aanwezig met near-infrared. Maar ook de kleur van voedsel bevat veel meer informatie voor de robot dan voor ons.

- Onregelmatigheden op de huid van mens en dier. Ook deze kan een robot zien en wij niet. Denk aan huidkanker, meteen spotten is hogere overlevingskans! Iedere spiegel met een goede camera erin zou jou en je gezin dagelijks zonder gedoe kunnen checken.

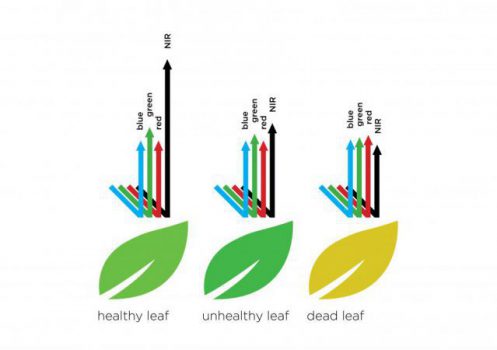

- De gezondheid van gewassen. Vanuit een drone kan snel worden bekeken welke gewassen gezond of ziek zijn. Maar de drone ziet ook exact welke gewassen er staan via near-infrared.

- Verschillende kunststoffen die er voor ons hetzelfde uitzien. Als je bij de recycling van kunststoffen op mensen vertrouwt dan gooi je allerhande soorten bij elkaar. Dat is zeer ongewenst in een circulaire economie.

Bovenstaande voorbeelden zijn puur ter illustratie en om je te prikkelen zelf na te denken over de mogelijkheden.

Ik wil Randall boeken Bekijk Randall op Linkedin

Randall is een ‘disruptive technology strategist’ voor uw keynotes en specifieke workshops. Tevens is Randall te boeken als dagvoorzitter voor innovatiedagen en congressen.